“All organizations start with WHY, but only the great ones keep their WHY clear year after year” – Simon Sinek.

“All organizations start with WHY, but only the great ones keep their WHY clear year after year” – Simon Sinek.

Pour retrouver les 18 minutes d’extrait de la conférence TEDx de Simon Sinek (sous-titrée en français), scannez le QR code présent dans l’image.

Pourquoi se demander pourquoi ? Appliquer le fameux “Start with Why” de Simon Sinek à la démarche d’évaluation de la formation, c’est revenir à l’intention avant de décliner l’action.

Mais alors pourquoi ? La réponse devrait jaillir comme un mantra : donner du sens à l’action de formation pour toutes les parties prenantes, de l’apprenant à l’entreprise, en passant par le manager et l’organisme de formation. A cela s’ajoute la nécessité pour l’entreprise d’essayer de percevoir la valeur ajoutée des actions qu’elle entreprend et la productivité des investissements qu’elle réalise en la matière.

Pourquoi la réalité est souvent plus nuancée ? Parce que souvent l’on oublie un autre Pourquoi : « Pourquoi est-ce que je forme mes collaborateurs ? » Le rythme de l’entreprise, le temps contraint, l’impératif de production orientent généralement vers le « Comment », reléguant le « Pourquoi » à une obligation légale ou à une pratique ancrée dont le sens et la finalité se perdent dans les losanges d’un logigramme qualité ou à une charte de valeurs d’entreprise qu’il serait malvenu d’occulter…

Revenir au “pourquoi” de la formation, aux objectifs de l’entreprise et à ceux de l’apprenant permettra de définir les indicateurs sur lesquels vont porter l’évaluation pour lui conférer du sens et de la valeur. Quant au « Comment » évaluer, il repose sur des méthodes plus ou moins complexes dont la plus connue est le modèle de Kirkpatrick.

1.

Pourquoi l’évaluation

n’est pas toujours une science exacte ?

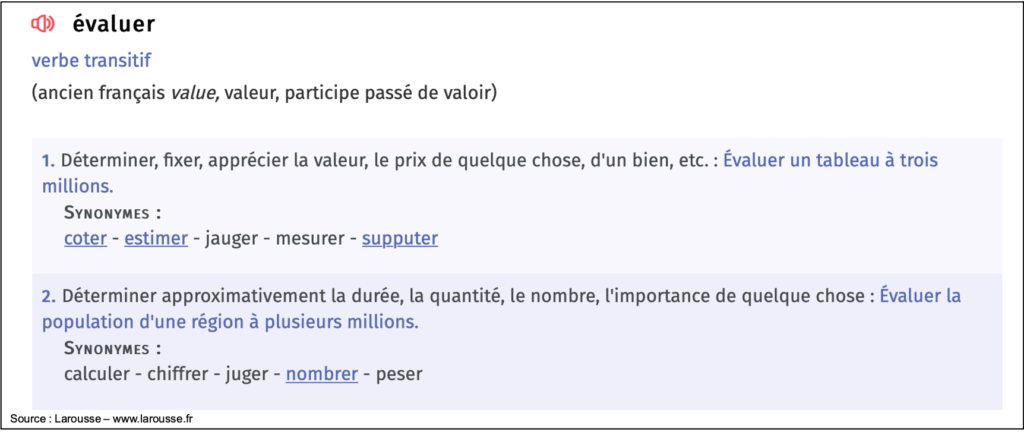

Le verbe évaluer porte, dans sa définition comme dans son étymologie, une dimension comptable. Et c’est bien dans cette notion de mesure donc de quantitatif que réside souvent la difficulté de l’évaluation de la formation.

Tous les éléments qui concourent à l’atteinte des objectifs d’une action de formation seraient-ils quantifiables ? L’environnement de travail, l’implication du manager, la motivation de l’apprenant, le moment de réalisation de la formation sont difficiles à convertir en données chiffrées ou même en coefficients. Ils n’en demeurent pas moins des variables qui conditionnent l’efficacité et l’impact de la formation. C’est la raison pour laquelle l’entreprise qui a l’habitude de parler de ROI (retour sur investissement) a intérêt à considérer également un ROE (retour sur les attentes) en formation.

Se former ne se résume pas à suivre une formation

Évaluer l’action de formation irait donc bien au-delà de mesurer. Il est souvent difficile d’isoler les effets d’une formation. En cours de formation, les apports qu’ils soient théoriques ou opérationnels, délivrés dans les temps formels dédiés, constituent l’un des éléments de la montée en compétence. L’interaction de l’apprenant avec son équipe, avec des prestataires ou même dans sa sphère privée peuvent participer à l’acquisition de savoirs, savoir-faire ou savoir-être liés et à leur transfert en situation de travail.

De même une action de formation dispensée en intra à l’ensemble d’une catégorie de collaborateurs pourra se révéler plus efficace que la même formation délivrée à un seul collaborateur, car les acquis seront partagés par tous. On est ici en présence d’une des externalités positives de la formation : l’environnement motivant dans lequel évolue le salarié formé.

Pour autant, la notion de mesure apporte un caractère objectif et objectivable à toute action d’évaluation. C’est sans doute la raison pour laquelle le modèle de Kirkpatrick qui, bien que largement critiqué, continue à faire référence. Il conserve un caractère actionnable avec un investissement en temps et en compétences statistiques raisonnable là où d’autres modèles d’analyses plus poussés nécessitent de faire appel à un statisticien chevronné.

2.

Pourquoi mettre les mêmes efforts d’évaluation

sur toutes les formations ?

L’entreprise a-t-elle intérêt à évaluer de façon poussée toutes ses actions de formation ? Là encore revenir au « Pourquoi l’on forme » peut permettre d’identifier les enjeux de l’évaluation. Une question à compléter par les « Comment et Qui l’on forme ».

Il est probable qu’une formation métier représente un enjeu business supérieur et plus immédiat qu’une formation visant à développer l’efficacité professionnelle ou le développement personnel. La formation métier va viser un objectif de changement immédiat dans les savoir-faire et la croissance de l’entreprise.

Exemples :

- Un commercial formé sur les techniques de social selling en post-COVID sera attendu dès la fin de sa formation sur sa capacité nouvelle à ouvrir des comptes et obtenir des rendez-vous via les réseaux sociaux. Ses objectifs chiffrés en la matière auront sans doute été précisément définis. En effet sa formation devrait constituer une réponse à une orientation stratégique qui impacte directement les objectifs business de l’entreprise.

- A l’inverse, un manager inscrit à une formation « Feedback » sera sans doute attendu à plus long terme et l’impact souhaité ne portera sans doute pas directement sur le chiffre d’affaires. Il pourra porter sur la limitation du turn-over, sur la fluidité des relations dans l’équipe, sur la prise de responsabilités…

Il en va sans doute de même pour une formation destinée à un grand nombre de collaborateurs par rapport à celle dédiée à un salarié. L’investissement temps et argent et les attendus seront généralement supérieurs dans le premier cas et l’enjeu de l’évaluation en sera accru.

Exemples :

- Une formation conduite du changement de l’ensemble des managers aura sans doute des objectifs d’opérationnalité immédiate dans les équipes pour porter les nouvelles orientations stratégiques de l’entreprise et assurer une meilleure gestion de la performance collective, des délais ou des budgets… L’évaluation cherchera alors à démontrer le transfert des acquis et l’impact organisationnel.

- A l’inverse, la même formation sur un collaborateur unique dans une session inter-entreprises aura-t-elle des attendus plus limités sur le développement de l’activité, la fluidité des process, la conduite du changement… Dans ce cas, l’évaluation de la satisfaction et des acquis aura-t-elle plus d’importance que l’évaluation de l’impact.

Et pour affiner encore les distinctions, une formation longue, diplômante et onéreuse dispensée à un collaborateur dans une optique de mobilité interne sur un poste clé pourra être évaluée sur l’ensemble des niveaux, de la satisfaction à l’impact et jusqu’au ROI.

Définir des cas d’usage d’évaluation de ses formations au regard du plan de développement des compétences peut permettre de gagner du temps et d’alléger les sollicitations des personnes à même d’évaluer les transferts ou l’impact si l’enjeu est faible.

3.

Pourquoi les 4 niveaux de Kirkpatrick

restent une référence ?

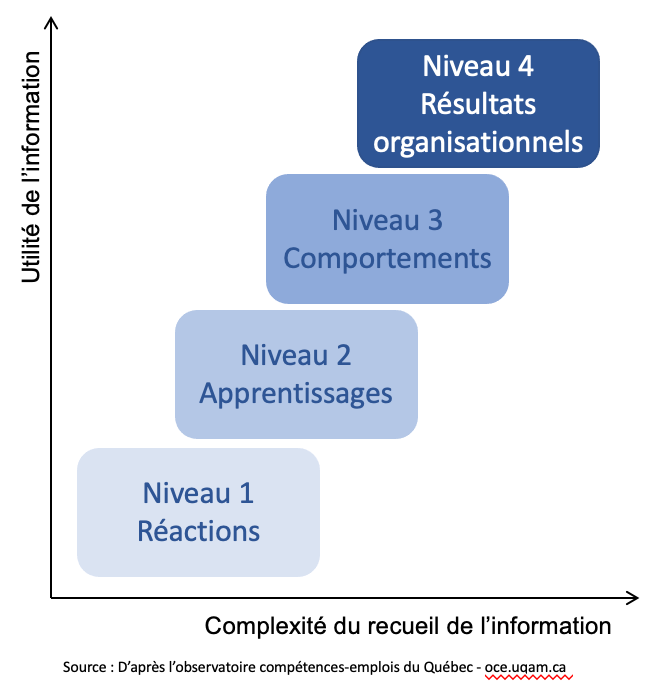

Quiconque s’est un jour intéressé de près à la formation, a entendu prononcer le nom de Kirkpatrick. Son modèle, élaboré dans les années soixante puis enrichi en 2010 par ses descendants, s’est imposé par sa simplicité (relative mais réelle si on le compare aux nombreux autres modèles existants dans le monde merveilleux de l’évaluation de la formation). Il fonctionne comme un guide méthodologique utile pour accompagner une réflexion sur les critères de l’évaluation.

Son opérationnalité en fait le modèle le plus utilisé actuellement malgré ses limites et les critiques dont il a été et est encore aujourd’hui l’objet.

Il est bâti sur une démarche en 4 niveaux successifs et interdépendants (chaque niveau étant lié à la validation du niveau précédent) d’évaluation :

- Niveau 1 : la satisfaction, autrement dit le ressenti des apprenants face au parcours

- Niveau 2 : les acquis, c’est-à-dire la mesure des apprentissages

- Niveau 3 : le transfert ou capacité à mobiliser les compétences nouvelles dans une situation de travail réelle

- Niveau 4 : les résultats que l’on qualifiera d’impact de la formation au niveau non plus de l’individu mais de son entreprise

Niveau 1 : les apprenants sont-ils satisfaits de la formation qu’il s’agisse du contenu, du rythme, de l’accompagnement, de la durée, du niveau de difficulté ?

L’évaluation est réalisée au moyen de questionnaires à chaud puis à froid, de l’analyse des commentaires des apprenants tout au long du parcours de formation, des messages postés sur les forums le cas échéant. Ce niveau ne vise pas à valider les acquis.

Sa simplicité de mise en œuvre et l’obligation légale d’évaluation dont il fait l’objet en font un niveau évalué systématiquement ou presque. En revanche, son exploitation à des fins d’amélioration continue pour corriger les éventuels points faibles de la formation remontés par les apprenants est loin d’être une pratique courante.

Niveau 2 : les apprenants ont-ils retenus/compris/acquis les notions, process, démarches, concepts ou postures qui leur ont été présentés ?

On se positionne ici sur un critère d’efficacité individuelle. Ce niveau évalue l’efficacité pédagogique de la formation. Cette étape est assurée au travers des évaluations formatives et sommatives prévues dans le parcours : tests, quiz, cas pratiques, mises en situation voire certification ou examen.

Cet indicateur est d’autant plus fiable qu’un test de positionnement aura été réalisé en début de formation et un test de validation en fin de parcours, permettant, au travers de l’écart constaté, de mesurer une progression.

Niveau 3 : l’apprenant a-t-il modifié son comportement suite à la formation pour mettre en œuvre, dans son quotidien professionnel, les compétences acquises ?

Ce troisième niveau concerne le transfert des acquis en situation de travail. Il s’agit ici de valider les changements de comportement chez les apprenants. Ce niveau nécessite d’avoir une idée précise des changements attendus chez l’apprenant ou des savoir-faire ou savoir-être à mobiliser. Cette évaluation ne peut pas être réalisée dès la fin de la formation. Il faut laisser à l’apprenant quelques semaines pour intégrer ces nouveaux réflexes acquis en formation dans sa pratique quotidienne et à son manager le temps de constater l’évolution chez son collaborateur. Ce niveau relève de l’efficacité du dispositif. L’évaluation prend la forme de questionnaires ou d’interviews destinés à sonder l’apprenant mais également son manager et éventuellement ses collègues sur les nouvelles pratiques mises en œuvre. Sa pertinence sera renforcée par un positionnement sur les pratiques ou les postures de l’apprenant en début de formation et la constatation sinon la mesure de l’écart après la formation.

Niveau 4 : la formation a-t-elle eu un réel impact sur l’activité/l’organisation de l’entreprise ?

Ce dernier niveau du modèle de Kirkpatrick, l’évaluation des résultats de l’action de formation va permettre de prendre du recul pour passer de l’efficacité individuelle à l’impact organisationnel du dispositif formatif. On est ici sur le ROE (retour sur les attentes).

Parvenir à identifier la part de la performance et des évolutions individuelles concourant à l’atteinte des objectifs de l’entreprise et imputable à l’action de formation nécessite d’avoir élaboré des indicateurs très précis lors de l’analyse des besoins. Cette analyse est effectuée en amont de la formation.

Cette évaluation n’est pas réalisée dès la fin de la formation. Elle peut être programmée avec des échéances précises (au terme du pic d’activité en cas de forte saisonnalité, par exemple) et avec une récurrence clarifiée dès le départ pour mesurer en outre la viabilité et la pérennité du dispositif.

Le Bonus de Phillips

A la fin des années 90, Jack Phillips complète le modèle de Kirkpatrick en lui ajoutant un 5e niveau quantitatif : le ROI (retour sur investissement). Après avoir dégagé les apports qualitatifs de l’action de formation au travers des 4 niveaux de Kirkpatrick, l’entreprise peut alors tenter de quantifier le bénéfice apporté par la formation par rapport à l’investissement qu’elle a nécessité.

A la fin des années 90, Jack Phillips complète le modèle de Kirkpatrick en lui ajoutant un 5e niveau quantitatif : le ROI (retour sur investissement). Après avoir dégagé les apports qualitatifs de l’action de formation au travers des 4 niveaux de Kirkpatrick, l’entreprise peut alors tenter de quantifier le bénéfice apporté par la formation par rapport à l’investissement qu’elle a nécessité.

Concrètement, le ROI est égal au rapport du bénéfice net dégagé par les équipes formées, sur le coût global de l’action de formation.

Cette évaluation ne s’entend qu’après réalisation des 4 niveaux du modèle de Kirkpatrick qui posent la définition des objectifs pédagogiques mais également des objectifs organisationnels de la formation. Parvenir à un ratio pertinent peut s’avérer complexe en formation. L’opération nécessite des outils de reporting précis qui se révèlent potentiellement difficiles à alimenter.

Retrouvez un résumé des partis-pris de Phillips (en anglais) en scannant le QR-Code

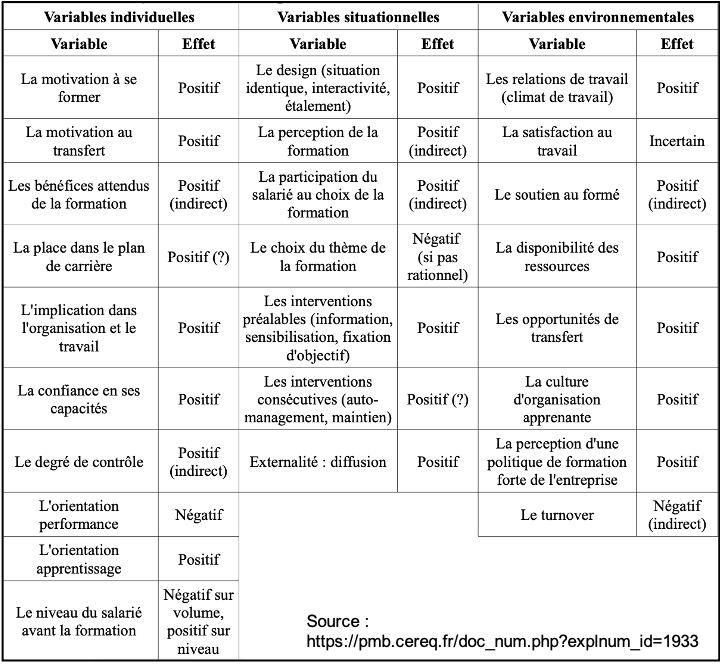

En outre, de nombreuses variables humaines, relationnelles, organisationnelles influencent l’efficacité d’une formation et biaise les évaluations purement quantitatives.

Dans une étude de 1993, le Cereq avait recensé quelques-unes de ces variables et leur effet sur la formation.

4.

Pourquoi l’évaluation

n’est pas une activité post-formation ?

L’évaluation n’est pas une mesure à un instant « t » post formation. C’est une démarche qui s’inscrit dans le temps et débute avant même la formation.

Pour évaluer le transfert des acquis en situation de travail, l’impact de la formation et en mesurer le ROE (retour sur les attentes), niveaux 3 et 4 du modèle de Kirkpatrick, encore faut-il définir précisément les attentes et les besoins de l’organisation. De cette définition, découleront les objectifs de la ou des formations nécessaires. Viendront ensuite les indicateurs, propres à chaque situation, qui permettront d’évaluer de façon qualitative et quantitative les résultats de l’action de formation.

Ce processus va permettre d’identifier les indicateurs pertinents. De façon plus large, quelle que soit la méthodologie ou le modèle d’évaluation utilisés, la définition d’objectifs SMART (Spécifique, Mesurable, Atteignable, Réaliste, Temporel) est un incontournable de tout projet.

L’analyse du besoin et les indicateurs

L’analyse du besoin vise à recueillir un grand nombre d’informations sur la nature des compétences requises pour réaliser une mission, le niveau de compétences des collaborateurs chargés de réaliser ladite mission et l’écart entre les deux. La formation sert ainsi à combler cet écart. Et les indicateurs seront pertinents au vu du contexte et des attentes.

L’analyse du besoin vise à recueillir un grand nombre d’informations sur la nature des compétences requises pour réaliser une mission, le niveau de compétences des collaborateurs chargés de réaliser ladite mission et l’écart entre les deux. La formation sert ainsi à combler cet écart. Et les indicateurs seront pertinents au vu du contexte et des attentes.

Concernant la satisfaction des apprenants et la validation de de leurs acquis, l’indicateur est généralement plus simple à à définir et les informations faciles à obtenir. On peut viser une satisfaction supérieure à 80% et une validation des acquis attestée par une note supérieure à 15/20, par exemple.

Pour évaluer le transfert des acquis en situation de travail et l’impact organisationnel de la formation, le travail est plus conséquent, la définition précise du besoin et des indicateurs plus complexes et les données plus difficiles à recueillir. Ce sont généralement par ces deux niveaux les plus hauts que l’on commence pour définir les attentes et les indicateurs.

Les attentes opérationnelles en matière de modification des comportements du collaborateurs sont à déterminer avec précision en concertation avec le manager direct de l’apprenant. Les attentes et les besoins organisationnels sont définis en concertation avec la direction générale de l’entreprise pour aligner la formation avec les objectifs business.

Quelques exemples sur les niveaux de transfert et d’impact

- Modification des process : digitalisation synchrone des formations présentielles

- Compétences visées : ingénierie pédagogique digitale et animation de classes virtuelles

- Exemple d’indicateur de transfert : production de séquences courtes et impactantes avec une progression croissante et pertinente du niveau de

- difficulté pour l’apprenant, mesurée par le retour du formateur et par la satisfaction des apprenants qui doit dépasser les 80%

- Exemple d’indicateurs d’impact : hausse du nombre de formés de 15% et baisse de 10% du coût des formations

- Adoption d’un nouvel outil : changement de la solution de classes virtuelles

- Compétences visées : utilisation fluide du nouvel outil et de ses fonctionnalités

- Exemple d’indicateur de transfert : réalisation de la séquence sans problème technique dans le respect de la durée, évaluée par la satisfaction des

- apprenants supérieure à 80% et les données de connexion sur la solution

- Exemple d’indicateur d’impact : rationalisation du nombre d’outils utilisés dans l’entreprise

- Baisse de motivation dans une équipe : problème de disponibilité du manager

- Compétences visées : gestion du temps

- Exemple d’indicateur de transfert : nombre de points en one to one réalisés avec chaque collaborateur sur une période cible

- Exemple d’indicateur d’impact : réduction à moins de 2% du nombre de problèmes spécifiques à cette équipe remontés en CSE

- Mécontentement croissant des clients : problème de réactivité du service client

- Compétences visées : priorisation des tâches

- Exemple d’indicateur de transfert : classement des demandes selon l’urgence et non selon l’ordre d’arrivée

- Exemple d’indicateur d’impact : baisse des réclamations clients de 10%

C’est pour quand ?

Si la démarche d’évaluation débute en amont de la formation avec la définition des attentes, des besoins et des indicateurs, elle se déroule tout au long de la formation, avec notamment l’évaluation continue des acquis (niveau 2 de Kirkpatrick) au travers de quiz, cas pratiques, mises en situation. Elle s’étale ensuite post-formation sur une durée variable selon les compétences visées.

Évaluer un transfert de compétences en situation de travail (niveau 3 de Kirkpatrick) peut s’avérer plus ou moins long. Dans le cadre de la prise en main d’un nouvel outil, mesurer la bonne appropriation peut être relativement rapide si le manager et/ou l’entreprise donne(nt) à l’apprenant l’occasion d’utiliser l’outil dès le retour de formation. Il en va de même sur la maîtrise d’une nouvelle méthodologie si celle-ci comporte peu d’étapes.

En revanche sur la mobilisation d’un nouveau process de gestion multi-projets par exemple, l’évaluation ne pourra être pertinente avant la réalisation complète d’un cycle de gestion de projets. Il peut alors être intéressant d’évaluer le transfert phase par phase.

Concernant les soft skills, la modification du comportement peut prendre du temps et nécessitera sans doute un encouragement de la part de l’équipe et du manager dans la durée pour mesurer l’appropriation de la nouvelle posture. Il s’agit là encore d’une évaluation avec des étapes à clarifier.

Cette durée d’étalement de l’évaluation est également liée à la durée de la formation. Une formation de plusieurs centaines d’heures aura permis un entraînement et un ancrage plus fort et plus visible au sortir de la période de formation proprement dite. L’évaluation pourra alors démarrer plus tôt.

5.

Pourquoi l’évaluation de la formation

n’est pas l’évaluation de l’apprenant pour l’apprenant ?

L’évaluation de la formation s’arrête souvent aux deux premiers niveaux de Kirkpatrick, soit une évaluation de satisfaction par l’apprenant pour le niveau 1 et une mesure des acquis pour le niveau 2. Cette situation correspond à une approche très individuelle de l’évaluation qui passe alors par les seules réponses des apprenants, alors même que la prise en compte des retours des autres parties prenantes (formateurs, manager, service RH, équipe de l’apprenant) sont cruciales. Intégrer ces retours constitue une façon de prendre en compte les interactions de l’apprenant avec son environnement de formation et son environnement professionnel.

De même considérer tous les niveaux d’évaluation permet à chacune des parties prenantes de tirer les bénéfices de la formation ne serait-ce qu’en termes d’informations pour la planification des formations futures.

Où sont les managers ?

Il n’est évidemment pas question de mettre en cause les managers ou plutôt leur absence d’implication dans la formation de leurs collaborateurs. Leur agenda chargé ne leur offre souvent guère le temps d’un accompagnement individuel à la mise en application de la formation suivie par chacun des membres de leur équipe.

En outre l’exercice est loin d’être simple. Définir les critères objectifs capables de refléter la progression d’un collaborateur est une action complexe et chronophage. Le service formation prend ici toute sa place pour guider le manager dans la définition non seulement des critères mais également des tâches à confier au collaborateur pour faciliter le transfert des acquis et in fine mesurer l’impact. Une grille d’entretien précise élaborée par le responsable formation qui, peut ici se faire aider de l’organisme de formation, peut guider la réflexion du manager (mais également de l’apprenant qui peut avoir des idées de mise en pratique immédiate et d’indicateurs pertinents) pour dégager les critères clés.

Cette définition des critères et indicateurs sert tous les acteurs de la formation :

- l’apprenant au premier chef pour conscientiser ses apprentissages, développer son sentiment d’efficacité et de sécurité vis-à-vis de son employabilité et renforcer sa motivation à appliquer au quotidien ses acquis ;

- le manager pour se projeter sur un levier « compétences » d’atteinte de ses objectifs ;

- le responsable formation pour aligner le plan de développement des compétences avec les objectifs business de l’entreprise ;

- l’organisme de formation pour valider ses partis pris pédagogiques, son format d’animation, la pertinence de son parcours par des cas d’usage concrets et opérationnels et le cas échéant ajuster le déroulé de la formation ;

- l’entreprise dans ses projections de croissance et de développement et la sécurisation de ses actifs immatériels de connaissance et compétences.

L’évaluation de la formation va donc bien au-delà d’une simple réponse à une obligation réglementaire.

Pour conclure

Toute démarche d’évaluation de la formation débute avant la phase de déploiement du parcours par une analyse des objectifs, des besoins et des attentes, qu’ils soient stratégiques, opérationnels ou purement pédagogiques.

Le temps à consacrer à la préparation de l’évaluation peut varier en fonction de l’enjeu stratégique de la formation. L’évaluation peut selon les cas s’arrêter aux deux premiers niveaux ou au contraire être menée sur les 5 niveaux (4 niveaux de Kirkpatrick et le niveau 5 de Phillips). A noter, le niveau 3 du modèle de Kirkpatrick n’est abordé que dans 35 % des cas et ce taux chute à 15 % pour le niveau 4.

Les niveaux supérieurs de transfert, d’impact et ROI nécessitent de contextualiser la démarche et les indicateurs aux spécificités de l’entreprise, de son marché et de ses perspectives de croissance. La méthode doit être en phase avec la culture d’entreprise. Le temps nécessaire à la préparation et à la mise en œuvre ne doit pas être sous-estimé.

Toutes les parties prenantes doivent être associées à la réflexion sur les attentes et les indicateurs. L’évaluation à forte valeur ajoutée va au-delà d’un score de satisfaction ou d’étoiles dorées qui font la fierté des services marketing.

Au terme de l’évaluation, les résultats doivent être communiqués à l’ensemble des parties prenantes. L’évaluation n’est enfin pas une fin en soi. Elle est l’élément objectivable de l’efficacité voire de l’efficience de l’action de formation. A ce titre, elle doit être suivie d’un plan d’action pour ajuster le parcours et combler les écarts constatés entre les attendus et les résultats constatés.

N’hésitez pas à interroger des professionnels de l’évaluation pour mettre en place une démarche structurée et exploitable.

POURQUOI NE PAS SE LANCER ?